大模型的泡沫什么时候破灭?

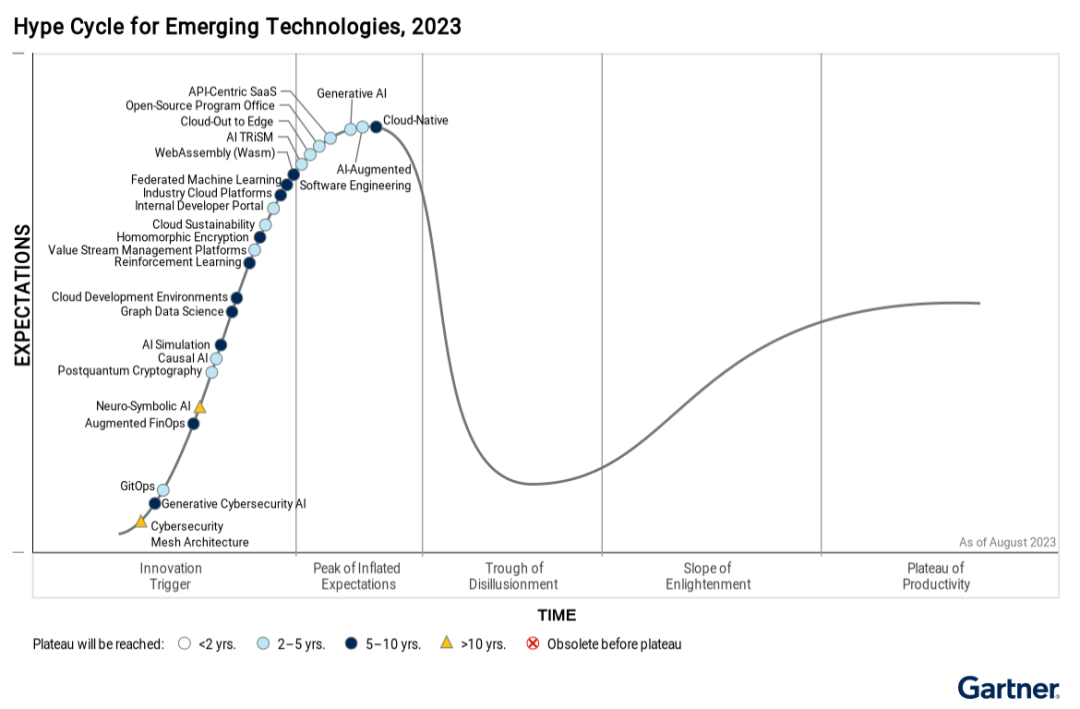

对于技术泡沫,大家可能最熟悉的就是 Gartner 的技术成熟度曲线图。过去几年确实出现了许多备受关注的技术,例如云计算、大数据、区块链和元宇宙。新技术让人激动,但很多企业在跟进这些技术时往往犹豫不决,担心不下注未来会被淘汰,也担心投入巨大但方向错误。例如,前几年 Facebook 押注元宇宙,甚至将公司名称改为 Meta,但元宇宙的技术成熟度和市场发展并未达到预期。幸好,Meta 公司在大模型时

对于技术泡沫,大家可能最熟悉的就是 Gartner 的技术成熟度曲线图。过去几年确实出现了许多备受关注的技术,例如云计算、大数据、区块链和元宇宙。新技术让人激动,但很多企业在跟进这些技术时往往犹豫不决,担心不下注未来会被淘汰,也担心投入巨大但方向错误。

例如,前几年 Facebook 押注元宇宙,甚至将公司名称改为 Meta,但元宇宙的技术成熟度和市场发展并未达到预期。幸好,Meta 公司在大模型时代及时调整方向,特别是在开源大模型上为社区作出了巨大贡献。那么,这次大模型的技术发展周期是怎样的,会出现短期见顶的情况吗?

Meta 于 7 月 23 日发布了 Llama 3.1 405B 开源人工智能模型,这是 Meta 迄今为止最强大的模型,也是目前全球最强大的开源大模型。在某些方面,超大杯 Llama 3.1 405B 超过了 GPT-4 0125,与 GPT-4o 和 Claude 3.5 互有胜负。例如,它在 NIH/Multi-Needle 基准测试中的得分为 98.1,在 ZeroScrolls/Quality 基准测试中的得分为 95.2,在处理长文本方面表现出色,在 Human-Eval 基准测试中也略占上风。

从最终效果来看,大力仍能出奇迹,Scaling Law 依然有效。在 Llama3.1 的大模型中,70B 和 8B 大小参数的模型也比之前的版本有了非常大的性能提升,这两个规模的开源模型非常适合企业部署。

从 2022 年底 OpenAI 推出大模型后,从一开始的聊天应用,到后来的 RAG,Agent,多模态,视频处理等,AI 的应用落地实践其实是越来越成熟,开源的大模型也被广泛应用在企业的各种业务场景中。

但是由于所有的大模型都几乎用同一套标准的接口,使得大模型很难像传统软件那样打造专属的生态圈,从而建立竞争护城河。用户从一个大模型切换到另外一个大模型,几乎不需要什么成本,每个月都会有更新更好用成本更低的大模型出来。这也使得市场和投资界对大模型的商业价值持疑态度,认为其发展可能类似于几年前的各种技术概念泡沫。

Llama 3.1 405 模型是在一个包含了 16384 块 Nvidia H100 80GB GPU 集群上训练了整整 54 天,其中出现了 417 次意外中断。如果按照每小时每张卡 3 美金的 H100 租赁成本,加上 CPU、内存、磁盘、网络等硬件资源每小时预计 5 美金的成本来算,这次训练就需要 1 亿美金的硬件成本。再加上数据购买、人工训练、维护和调优的费用,一次大模型的训练成本可能超过 2 亿美金。而目前 SpaceX 发射一次星舰火箭的成本也不到一亿美金,这已经是当前商业航天里运力最强的火箭。

目前,人类正以极大的热情投入 AI 领域,受益于 AI 的火热,英伟达的股价在两年内上涨了 10 倍以上,市值超过 3 万亿美元。每个月都有企业宣布推出新的大模型,消耗了几个小目标,不断地刷新榜单。这不禁让大家联想到 20 世纪 60 年代美苏争霸时期的太空竞赛。

1957 年苏联成功发射世界上第一颗人造卫星——斯普尼克一号。1958 年,苏联宇航员尤里·加加林成为第一个进入太空的人,乘坐东方 1 号(Vostok 1)绕地球飞行。这一事件引发了美国的极大震惊和反应,美国总统艾森豪威尔签署了《国家航空航天法》,成立了美国国家航空航天局(NASA),以应对苏联在太空竞赛中的领先地位。

在 1969 年,美国成功实现了载人登月计划。阿波罗 11 号任务中,尼尔·阿姆斯特朗(Neil Armstrong)和巴兹·奥尔德林(Buzz Aldrin)成为首批登上月球的人类。阿波罗计划共进行了 17 次任务,其中 6 次成功登月,最后一次是 1972 年的阿波罗 17 号。阿波罗计划的实际支出略高于预算,大约为 257 亿美元。按现值计算,其花费相当于 2000 亿美元,但它实现了人类历史上的重大突破。太空竞赛的角逐中,除了航天技术以外,还推动了计算机技术、材料科学和通信技术的进步,我们今天非常多的技术都孵化于当年的太空探索。

很多人可能会很好奇,既然登月计划那么成功,人类为什么没有继续转向火星和更远的太空呢?首先,技术上的挑战远超预期。火星距离地球遥远得多,火星到地球的距离约为月亮到地球距离的 586 倍;长达数月甚至数年的航行时间,以及在陌生星球上生活所需的复杂生命支持系统,都给科学家们带来了前所未有的难题。其次,高昂的成本也是一个无法忽视的因素,预计火星任务的预算将至少比阿波罗计划高 10 倍以上。现实是资源有限,必须优先处理地球上的诸多问题,地球上即使是生存条件最恶劣的地方也比月球和火星更宜居。

尽管当时的各国政府和科学家们对太空探索都充满热情,但下一个目标跨度太大、成本太高,让单纯的刷榜行为失去了动力。阿波罗登月这一事件被认为是太空竞赛的巅峰,之后美苏的竞争反而转向了地球轨道空间站和无人深空探测等方向。

目前,大模型的训练可能也会遇到类似的瓶颈,那就是下一个目标的成本可能高不可攀。目前最强的开源大模型已经达到了 4000 亿参数,但仍未实现通用人工智能。假设下一步量变引起质变的规模是十万亿参数,训练更大的模型往往需要更多的参数,其整体训练量和成本的增加远超过参数增长倍数。训练十万亿规模参数的大模型,可能需要几十万张 H100 的显卡的集群这样一次训练的成本可能达到 100 亿美元。从过去的太空竞赛来看,100 亿美元单个项目可能是目前人类社会能承受的极限。毕竟,下一个量级的百万亿参数大模型,其对应训练总成本很可能超过 1 万亿美元,这几乎是无法实现的。

如果 100 亿美金砸下去了,10 万亿规模参数的大模型还是没法实现 AGI,那么基于 Transformer 架构的大模型是不是短期就到头了?不过这个结果很可能会启发人们去探索 Transformer 之外的架构体系,例如量子计算,类脑芯片等。

10 万亿规模参数的大模型,会是 Transformer 架构的登月时刻么?

最后,笔者认为,在一次训练达到 100 亿美金成本之前,大家投入 AI 的热情是不会消退的,要谈泡沫破灭也得等到这个时间点到来之后。

零基础如何学习大模型 AI

领取方式在文末

为什么要学习大模型?

学习大模型课程的重要性在于它能够极大地促进个人在人工智能领域的专业发展。大模型技术,如自然语言处理和图像识别,正在推动着人工智能的新发展阶段。通过学习大模型课程,可以掌握设计和实现基于大模型的应用系统所需的基本原理和技术,从而提升自己在数据处理、分析和决策制定方面的能力。此外,大模型技术在多个行业中的应用日益增加,掌握这一技术将有助于提高就业竞争力,并为未来的创新创业提供坚实的基础。

大模型实际应用案例分享

①智能客服:某科技公司员工在学习了大模型课程后,成功开发了一套基于自然语言处理的大模型智能客服系统。该系统不仅提高了客户服务效率,还显著降低了人工成本。

②医疗影像分析:一位医学研究人员通过学习大模型课程,掌握了深度学习技术在医疗影像分析中的应用。他开发的算法能够准确识别肿瘤等病变,为医生提供了有力的诊断辅助。

③金融风险管理:一位金融分析师利用大模型课程中学到的知识,开发了一套信用评分模型。该模型帮助银行更准确地评估贷款申请者的信用风险,降低了不良贷款率。

④智能推荐系统:一位电商平台的工程师在学习大模型课程后,优化了平台的商品推荐算法。新算法提高了用户满意度和购买转化率,为公司带来了显著的增长。

…

这些案例表明,学习大模型课程不仅能够提升个人技能,还能为企业带来实际效益,推动行业创新发展。

学习资料领取

如果你对大模型感兴趣,可以看看我整合并且整理成了一份AI大模型资料包,需要的小伙伴文末免费领取哦,无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

部分资料展示

一、 AI大模型学习路线图

整个学习分为7个阶段

二、AI大模型实战案例

涵盖AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,皆可用。

三、视频和书籍PDF合集

从入门到进阶这里都有,跟着老师学习事半功倍。

如果二维码失效,可以点击下方链接,一样的哦

【CSDN大礼包】最新AI大模型资源包,这里全都有!无偿分享!!!

😝朋友们如果有需要的话,可以V扫描下方二维码联系领取~

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)