大数据技术----Spark实验

虚拟机之Spark环境搭建

| 安装Spark,解压安装包

修改名称,方便之后输入

sudo vim spark-env.sh 新建spark-env.sh文件,并进行配置

通过运行Spark自带的示例,验证Spark是否安装成功

通过grep过滤信息,查看示例结果

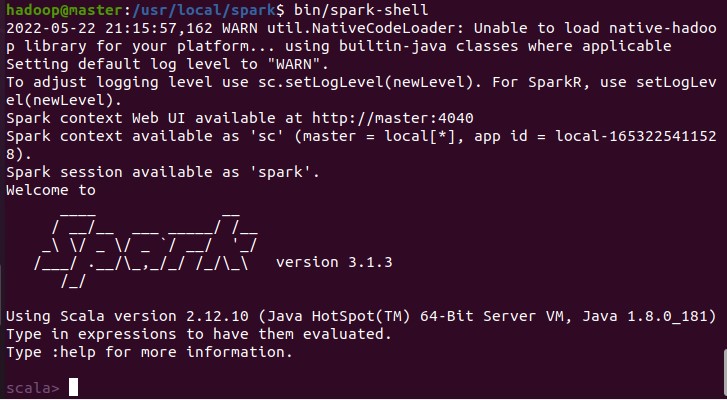

进入spark shell

加载text文件

获取RDD文件textFile的第一行内容

获取RDD文件textFile所有项的计数

抽取含有“Spark”的行,返回一个新的RDD

统计新的RDD的行数

找出文本中每行的最多单词数

退出spark shell

(一)编写Scala独立应用程序 创建安装目录

解压目录

把bin目录下的sbt-launch.jar复制到sbt安装目录下

sbt 可执行文件中添加如下信息

保存后,还需要为该Shell脚本文件增加可执行权限:

最后运行如下命令,检验 sbt 是否可用

进入用户主文件夹,并创建应用程序根目录

创建所需的文件夹结构

在 ./sparkapp/src/main/scala 下建立一个名为 SimpleApp.scala 的文件

我们需要通过 sbt 进行编译打包。 在~/sparkapp这个目录中新建文件simple.sbt。在simple.sbt中添加如下内容,声明该独立应用程序的信息以及与 Spark 的依赖关系

查看程序文件结构

我们就可以通过如下代码将整个应用程序打包成 JAR

将生成的 jar 包通过 spark-submit 提交到 Spark 中运行

(二)Java独立应用编程 手动安装maven,解压到/usr/local/maven中

在终端执行如下命令创建一个文件夹sparkapp2作为应用程序根目录

在 ./sparkapp2/src/main/java 下建立一个名为 SimpleApp.java 的文件(vim ./sparkapp2/src/main/java/SimpleApp.java),添加代码如下 该程序依赖Spark Java API,因此我们需要通过Maven进行编译打包。在./sparkapp2中新建文件pom.xml(vim ./sparkapp2/pom.xml),添加内容如下,声明该独立应用程序的信息以及与Spark的依赖关系

搜索spark-core可以找到相关依赖关系信息

为了保证maven能够正常运行,先执行如下命令检查整个应用程序的文件结构

通过如下代码将这整个应用程序打包成Jar

将生成的jar包通过spark-submit提交到Spark中运行

|

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)