spark入门【大数据spark】

1. spark简介Apache Spark 是专为大规模数据处理而设计的快速通用的计算引擎。2. Spark安装2.1 安装jdk2.2 配置spark官网下载spark安装包官网地址下载地址上传至虚拟机,修改配置文件spark-env.shexport JAVA_HOME=/root/app/langEnv/jdk8export SPARK_MASTE...

·

1. spark简介

Apache Spark 是专为大规模数据处理而设计的快速通用的计算引擎。

2. Spark安装

2.1 安装jdk

2.2 配置spark

-

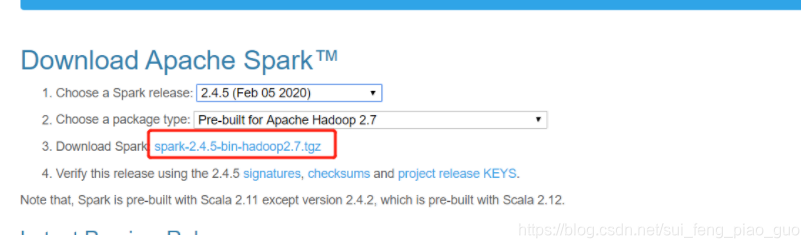

官网下载spark安装包

官网地址下载地址

-

上传至虚拟机,修改配置文件

- spark-env.sh

export JAVA_HOME=/root/app/langEnv/jdk8

export SPARK_MASTER_HOST=hadoop-master

export SPARK_MASTER_PORT=7077

- slaves

2.3 启动

-

命令:

./sbin/start-all.sh -

jps: Master、worker

-

web: http://192.168.200.168:8080/

3. spark Hello World

利用spark自带程序计算π的值

- 命令

./bin/spark-submit --master spark://hadoop-master:7077 --class org.apache.spark.examples.SparkPi examples/jars/spark-examples_2.11-2.4.5.jar 100

- 注意

- 默认每个executor使用一个G的内存,通过参数–executor-memory xxxmb指定(必须在jar之前)

- 默认一个任务会使用完所有的cpu核,通过参数–total-executor-cores num 指定

4.Spark-shell

-

启动本地模式

./bin/spark-shell -

集群模式

- 默认他也是一个spark-submit,并且默认占用所有的核以及1G的内存

./bin/spark-shell --master spark://hadoop-master:7077

- 默认他也是一个spark-submit,并且默认占用所有的核以及1G的内存

-

执行wordCount

- 注意:此处我是单机,如果是多机集群则每一个executor得机器上都需要对应的文件

sc.textFile("/root/testData/w.txt").flatMap(_.split(" ")).map((_, 1)).reduceByKey(_+_).collect

- 统计hdfs文件夹内所有文件的词频

sc.textFile("hdfs://hadoop-master:9000/words").flatMap(_.split(" ")).map((_, 1)).reduceByKey(_+_).collect

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)