windows下eclipse远程调试hadoop2.7.2,debug mapreduce

时间:2016年环境:windows:eclipselinux(虚拟机):hadoop集群windows下载hadoop-2.7.2解压到某目录下,如:E:\hadoop\hadoop-2.7.2为例下载hadoop-eclipse-plugin插件hadoop-eclipse-plugin,将release目录下的hadoop-eclipse-plugin-2.6.0.jar拷贝到ec

·

时间:2016年

环境:

windows:eclipse

linux(虚拟机):hadoop集群

- windows下载hadoop-2.7.2解压到某目录下,如:

E:\hadoop\hadoop-2.7.2为例 - 下载hadoop-eclipse-plugin插件hadoop-eclipse-plugin,将release目录下的

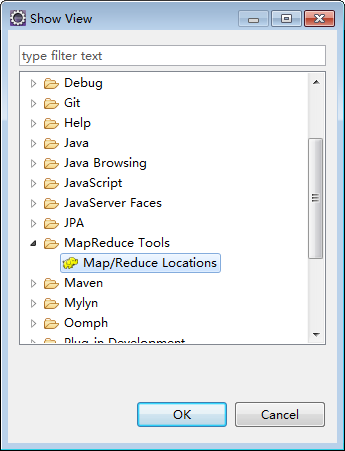

hadoop-eclipse-plugin-2.6.0.jar拷贝到eclipse/plugins,重启eclipse。 - 插件配置windows->show view->other

- window->preferences->hadoop map/reduce 指定win7上的hadoop根目录(即:

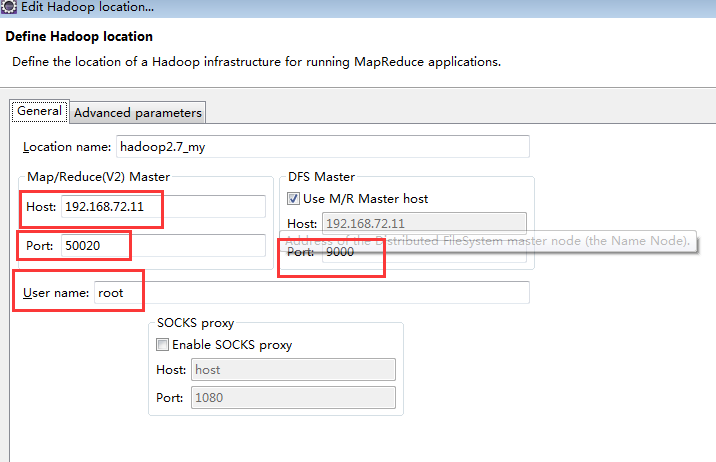

E:\hadoop\hadoop-2.7.2) - 然后在Map/Reduce Locations 面板中,点击小象图标定义hadoop

解释:

MapReduce Master

Host:虚拟机hadoop master对应ip

Port:hdfs-site.xml中dfs.datanode.ipc.address指定的的端口号。

DFS Master中Port:core-site.xml中fs.defaultFS指定的端口。

User name:linux中运行hadoop的用户。

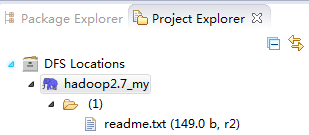

点击Finish。 - 查看hdfs文件。在Project Explore面板中查看。正常情况下是可以查看了。

- 但是一般不会具有写权限。原因是当前的win7登录用户不是虚拟机里hadoop的运行用户。如删除一个文件时,会报错某用户权限不足。解决方法:

在hdfs中所有文件都是由superuser用户组的用户上传的。所以将用户添加到该用户组即可。

groupadd supergroup

useradd -g supergroup -N -r 上述不具备权限用户完成。

权限解决方法二:

修改conf/core-site.xml,不检查权限。

将 dfs.permissions属性修改为false

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)