虚拟机开机,打开hadoop步骤,启动datanode失败解决办法(自用)

1、切换到hadoop解压后所在文件夹cd /opt/modules/hadoop-2.6.52、格式化bin/hdfs namenode -format3、启动进程sbin/start-all.sh4、输入jps检验所打开的进程问题:若因为多次格式化,而无法启动datanode,执行以下操作。1、切换到name、data文件所在路径,可以通过查看hdfs-site.xml配置...

1、切换到hadoop解压后所在文件夹

cd /opt/modules/hadoop-2.6.5

2、格式化

bin/hdfs namenode -format (不是每次开机都需要格式化)

3、启动进程

sbin/start-all.sh

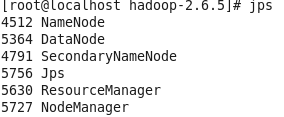

4、输入jps检验所打开的进程

问题:

若因为多次格式化,而无法启动datanode,执行以下操作。

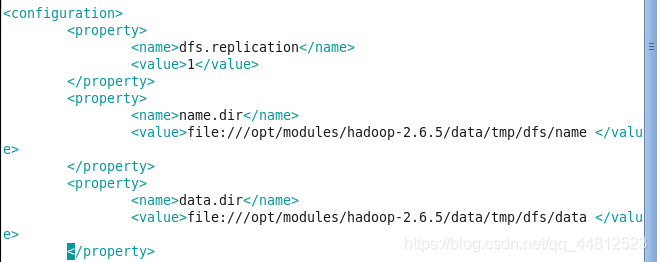

1、切换到name、data文件所在路径,可以通过查看hdfs-site.xml配置文件来确定文件路径。

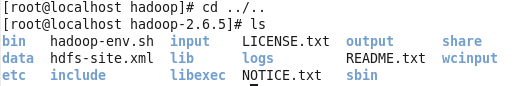

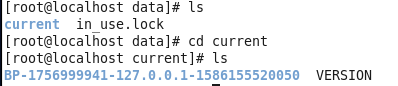

2、切换到hadoop-2.6.5位置,ls查看所包含的文件夹

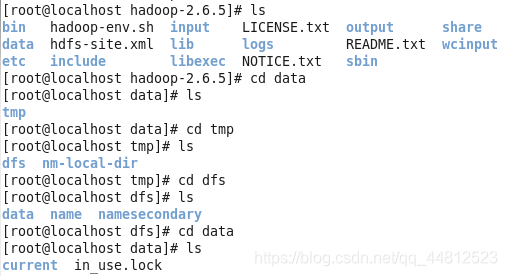

3、根据步骤一的路径,进入name、data文件夹

在name和data文件夹中都含有current,打开之后会发现VERSION

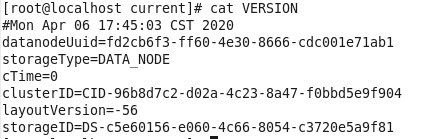

4、可以查看VERSION来了解clusterID

若name和data的VERSION所显示的clusterID不一致,则将导致datanode启动不了

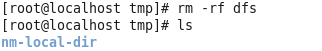

5、切换路径至/dfs/name的上一层,在终端中执行删除指令,将/dfs 整个文件夹删除。

rm -r dfs

这个命令执行的话,系统会一直询问是否删除,大概要回复好几屏的问题,所以还是选择强制删除更痛快一些。

rm -rf dfs

6、然后重新格式化,再重复开机后的命令就可以了,jps后发现进程可以启动了。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)