Keras中dense层原理及用法解释

文章目录一.全连接层Fully Connection作用二.API解释2.1 示例1:dense层为输入层2.2 示例2:dense层为中间层2.3 示例3:dense层为输出层三.实现过程四.数学解释一.全连接层Fully Connection作用全连接的核心操作就是矩阵向量乘积y=W∗xy =W*xy=W∗x本质就是由一个特征空间线性变换到另一个特征空间。因此,dense层的目的是将前面提取的

文章目录

一.全连接层Fully Connection作用

全连接的核心操作就是矩阵向量乘积

y

=

W

∗

x

y =W*x

y=W∗x

本质就是由一个特征空间线性变换到另一个特征空间。因此,dense层的目的是将前面提取的特征,在dense经过非线性变化,提取这些特征之间的关联,最后映射到输出空间上。

如下3x3x5的数据,转换成1x4096的形式。中间实现转换这个过程是一个卷积操作, 卷积操作就是利用了矩阵向量乘积的原理实现

我们用一个3x3x5的filter 去卷积激活函数的输出,得到的结果就是一个fully connected layer 的一个神经元的输出,这个输出就是一个值

FC层在keras中叫做Dense层,正在pytorch中交Linear层

二.API解释

keras.layers.Dense(units, activation=None, use_bias=True, kernel_initializer='glorot_uniform', bias_initializer='zeros', kernel_regularizer=None, bias_regularizer=None, activity_regularizer=None, kernel_constraint=None, bias_constraint=None)

参数解释如下(黑体为常用参数):

units :代表该层的输出维度或神经元个数, units解释为神经元个数为了方便计算参数量,解释为输出维度为了方便计算维度

activation=None:激活函数.但是默认 liner (详见API的activation)

use_bias=True:布尔值,该层是否使用偏置向量b

kernel_initializer:初始化w权重 (详见API的initializers)

bias_initializer:初始化b权重 (详见API的initializers)

kernel_regularizer:施加在权重w上的正则项 (详见API的regularizer)

bias_regularizer:施加在偏置向量b上的正则项 (详见API的regularizer)

activity_regularizer:施加在输出上的正则项 (详见API的regularizer)

kernel_constraint:施加在权重w上的约束项 (详见API的constraints)

bias_constraint:施加在偏置b上的约束项 (详见API的constraints)

2.1 示例1:dense层为输入层

# 作为 Sequential 模型的第一层,需要指定输入维度。可以为 input_shape=(16,) 或者 input_dim=16,这两者是等价的。

model = Sequential()

model.add(Dense(32, input_shape=(16,))) #其输出数组的尺寸为 (*, 32),模型以尺寸(*, 16) 的数组作为输入

# 在第一层之后,就不再需要指定输入的尺寸了:

model.add(Dense(32))

⚠️:作为 Sequential 模型的第一层,需要指定输入维度input_shape。

注意与input_dim区分:

- input_shape是指输入张量的shape

- input_dim是指的张量的维度

比如,一个一阶的张量[1,2,3]的shape是(3,),input_dim = 1(因为是一阶)

一个二阶的张量[[1,2,3],[4,5,6]]的shape是(2,3),input_dim = 2(因为是二阶)

一个三阶的张量[[[1],[2],[3]],[[4],[5],[6]]]的shape是(2,3,1),input_dim = 3(因为是三阶)

相反,如果input_dim=784,说明输入是一个784维的向量,这相当于一个一阶的张量,它的shape就是(784,)。因此,input_shape=(784,)。

2.2 示例2:dense层为中间层

这里使用的是Sequential模型,同时展示了dense作为输入层,中间层和输出层

from keras.models import Sequential

from keras.layers.core import Dense, Dropout, Activation

model = Sequential() # 顺序模型

# 输入层

model.add(Dense(7, input_shape=(4,))) # Dense作第一层要写input—_shape

model.add(Activation('sigmoid')) # 激活函数

# 隐层

model.add(Dense(13)) # Dense层为中间层

model.add(Activation('sigmoid')) # 激活函数

# 输出层

model.add(Dense(5))

model.add(Activation('softmax'))

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=["accuracy"])

model.summary()

2.3 示例3:dense层为输出层

这里使用的是Model模型,展示了dense层为输出层

from tensorflow.python.keras import *

from tensorflow.python.keras.layers import *

x=Input(shape=(5,))

y=Dense(1,activation='softmax')(x)

model=Model(inputs=x,outputs=y)

model.summary()

三.实现过程

O u t p u t = a c t i v a t i o n ( d o t ( i n p u t , k e r n e l ) + b i a s ) Output = activation(dot(input, kernel) + bias) Output=activation(dot(input,kernel)+bias)

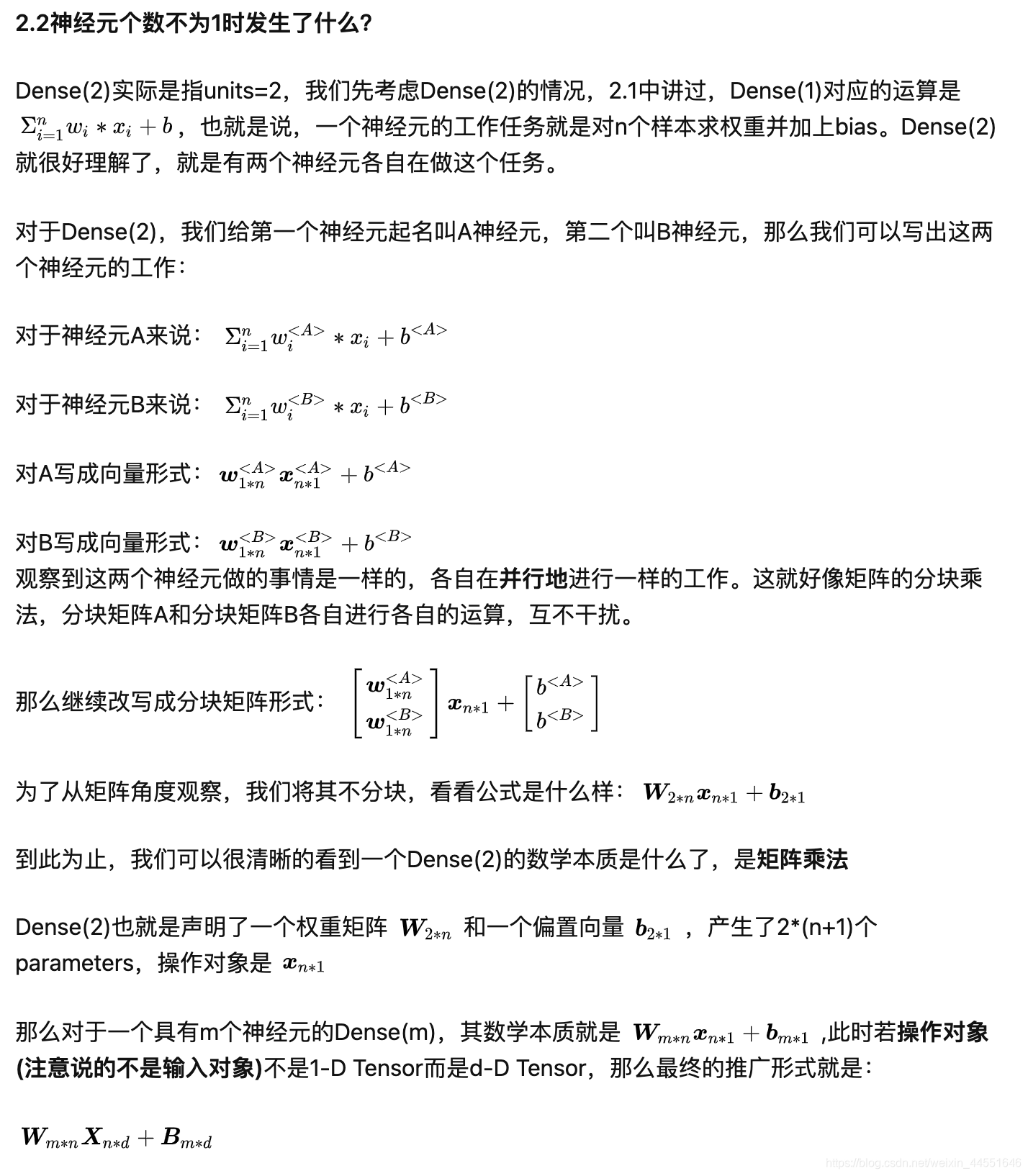

四.数学解释

该部分转载自:🔗

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)