RuntimeError: CUDA out of memory解决方法

RuntimeError: CUDA out of memory解决方法前言今天在运行代码的时候出现了cuda的一个报错,报错如下,意思就是超出内存了解决首先查看一下GPU使用情况,命令如下:nvidia-smi看输出的第二列(Memory_Usage)查看各个GPU使用情况找到剩余内存较大的GPU,然后代码中输入如下代码import osimport torchos.environ['CUDA_

·

RuntimeError: CUDA out of memory解决方法

前言

- 今天在运行代码的时候出现了cuda的一个报错,报错如下,意思就是超出内存了

解决

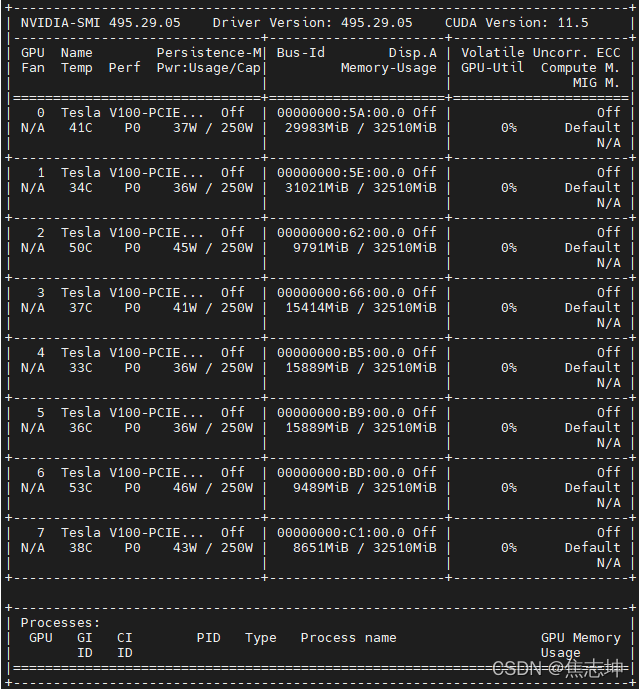

- 首先查看一下GPU使用情况,命令如下:nvidia-smi

- 看输出的第二列(Memory_Usage)查看各个GPU使用情况

- 找到剩余内存较大的GPU,然后代码中输入如下代码

import os

import torch

os.environ['CUDA_VISIBLE_DEVICES'] = '2,6' # 代表可以使用第二个和第六个GPU

device=torch.device("cuda:0") # cuda:0代表使用的是第二个GPU,cuda:1代表使用的是第六个GPU(按照索引取值)

总结

- 遇到cuda内存问题,首先查看那个GPU可以使用,然后设置环境参数CUDA_VISIBLE_DEVICES即可

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)