AUC、ACC、F1、准确率、召回率

准确率 - accuracy精确率 - precision召回率 - recallF1值 - F1-scoreROC曲线下面积 - ROC-AUC (area under curve)PR曲线下面积 - PR-AUC1 、aucAUC(Area Under Curve)被定义为ROC曲线下与坐标轴围成的面积,这个面积的数值不会大于1。又由于ROC曲线一般都处于y=x这条直线的上方,所以AUC的取值

准确率 - accuracy

精确率 - precision

召回率 - recall

F1值 - F1-score

ROC曲线下面积 - ROC-AUC (area under curve)

PR曲线下面积 - PR-AUC

1 、auc

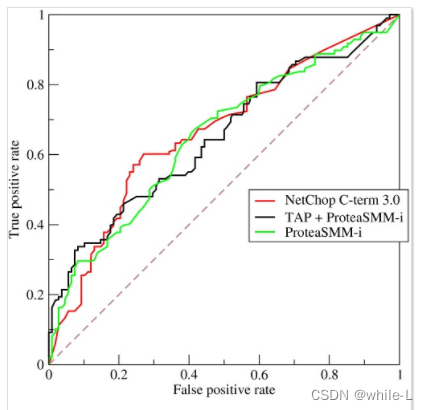

AUC(Area Under Curve)被定义为ROC曲线下与坐标轴围成的面积,这个面积的数值不会大于1。又由于ROC曲线一般都处于y=x这条直线的上方,所以AUC的取值范围在0.5和1之间。AUC越接近1.0,检测方法真实性越高;等于0.5时,则真实性最低,无应用价值。

ROC曲线全称为受试者工作特征曲线 (receiver operating characteristic curve),它是根据一系列不同的二分类方式(分界值或决定阈),以真阳性率(敏感性)为纵坐标,假阳性率(1-特异性)为横坐标绘制的曲线。

AUC就是衡量学习器优劣的一种性能指标。从定义可知,AUC可通过对ROC曲线下各部分的面积求和而得

ROC曲线的横坐标是假正类率(False Positive Rate),纵坐标是真正类率,(True Positive Rate),相应的还有真负类率,(True Negative Rate)和假负类率,(False Negative Rate)。这四类指标的计算方法如下:

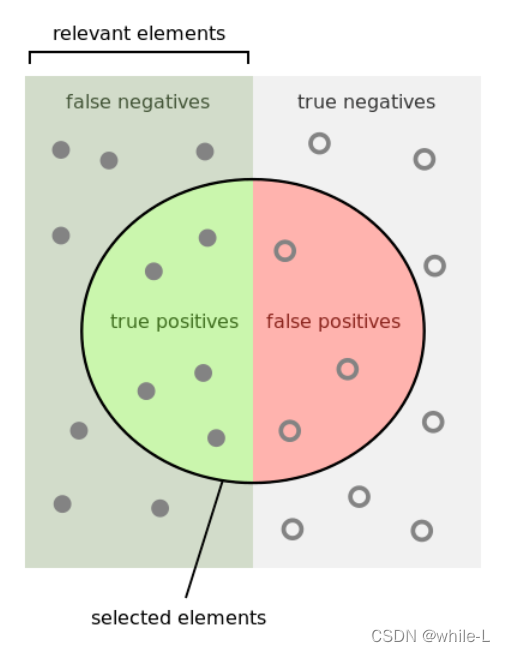

TP(True Positive):真正例,模型预测为正例,实际是正例

FP(False Positive):假正例,模型预测为正例,实际是反例

FN(False Negative):假反例,模型预测为反例,实际是正例

TN(True Negative):真反例,模型预测为反例,实际是反例

(1)假正类率(FPR):判定为正例却不是真正例的概率,即真负例中判为正例的概率

(2)真正类率(TPR):判定为正例也是真正例的概率,即真正例中判为正例的概率(也即正例召回率)

(3)真负类率(FNR):判定为负例却不是真负例的概率,即真正例中判为负例的概率。

(4)假负类率(TNR):判定为负例也是真负例的概率,即真负例中判为负例的概率。

TP + FP + TN + FN = 样本总数

比如我们有100个样本,其中90个为正,10个为负,然后我们训练一个模型,直接将100个样本都判定为阳性。这个时候混淆矩阵:

| TP = 90 | FN = 0 |

|---|---|

| FP = 10 | TN = 0 |

查准率 P = TP/(TP+FP) = 90/(90+10) = 0.9

查全率 R = TP/(TP+FN) = 90/(90+0) =1

一般查准率高时查全率比较低 ,查全率高时查准率比较低。

以西瓜书选西瓜为例:

如果希望把所有好瓜调出来,如果增加选瓜的数量,可将所有瓜选上,那所有好瓜就被选上了,这样查全率比较高,但是查准率下降。

如果希望选中好瓜比例尽可能高,只选有把握的瓜,那很多好瓜可能被遗漏,使得查全率下降,查准率上升。

2、acc 准确率

m个样本中有a个样本分类错误,则错误率为E=a/m ,精度 (acc)=1-错误率

有100个样本,其中90个为正,10个为负,然后我们训练一个模型,直接将100个样本都判定为阳性。这个时候准确率为:

1 - 10/100 = 0.9

3、recall 召回率

recall是相对真实的答案而言: true positive / golden set (你的模型能预测覆盖到多少)。

假设测试集里面有100个正例,如果你的模型预测到了40个正例,那你的recall就是40%。

4、precision

precision是相对你自己的模型预测而言:true positive /retrieved set。

假设你的模型一共预测了100个正例,而其中80个是对的正例,那么你的precision就是80%。

我们可以把precision也理解为,当你的模型作出一个新的预测时,它的confidence score 是多少,或者它做的这个预测是对的的可能性是多少。

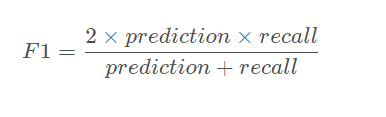

F1

参考资料

https://www.cnblogs.com/ai-ldj/p/14259041.html

https://blog.csdn.net/ritterliu/article/details/89452188

https://blog.csdn.net/qq_36426650/article/details/88073089

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)