报错:java.lang.NoSuchMethodError: org.apache.hadoop.hive.serde2.SerDeUtils.initializeSerDe

最开始报错:java.lang.NoSuchMethodError: org.apache.hadoop.hive.serde2.lazy.LazySimpleSerDe.initSerdeParams解决办法:javap -classpath hive-serde-0.13.1.jar org.apache.hadoop.hive.serde2.lazy.LazySimpleSerDe | gr

Spark 通过Hive中的外部表读Hbase表时报错:

java.lang.NoSuchMethodError: org.apache.hadoop.hive.serde2.SerDeUtils.initializeSerDe(Lorg/apache/hadoop/hive/serde2/Deserializer;Lorg/apache/hadoop/conf/Configuration;Ljava/util/Properties;Ljava/util/Properties;)V

最开始报错:

java.lang.NoSuchMethodError: org.apache.hadoop.hive.serde2.lazy.LazySimpleSerDe.initSerdeParams

解决办法:

javap -classpath hive-serde-0.13.1.jar org.apache.hadoop.hive.serde2.lazy.LazySimpleSerDe | grep initSerdeParams

发现类LazySimpleSerDe 中有方法initSerdeParams ,于是拷贝hive-serde-0.13.1.jar 到spark的jars目录下。

继续报错:

java.lang.NoSuchMethodError: org.apache.hadoop.hive.serde2.SerDeUtils.initializeSerDe(Lorg/apache/hadoop/hive/serde2/Deserializer;Lorg/apache/hadoop/conf/Configuration;Ljava/util/Properties;Ljava/util/Properties;)V

解决办法:关键提示为NoSuchMethodError。将hive-serde-0.13.1.jar解压,通过java反编译工具jd-gui.exe深入代码发现类SerDeUtils中确实没有initializeSerDe方法。判定为版本不兼容问题,尝试将apache-hive-0.13.1更换为能含有initializeSerDe的版本,使用apache-hive-0.14.0后成功解决该问题。需要分别从hbase和hive的lib目录下向spark中拷贝的jar包有:

hbase-client-0.98.6-cdh5.3.0.jar

hbase-common-0.98.6-cdh5.3.0.jar

hbase-protocol-0.98.6-cdh5.3.0.jar

hbase-server-0.98.6-cdh5.3.0.jar

hive-hbase-handler-0.14.0.jar

hbase-it-0.98.6-cdh5.3.0.jar

hbase-hadoop-compat-0.98.6-cdh5.3.0.jar

hbase-hadoop2-compat-0.98.6-cdh5.3.0.jar

high-scale-lib-1.1.1.jar

hive-serde-0.14.0.jar

htrace-core-2.04.jar

mysql-connector-java-5.1.27-bin.jar

此外:spark中原有的 htrace-core-3.0.4.jar不要删除!

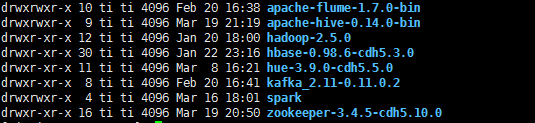

我的大致配置如下,其中spark为2.2.0,图片里没显示出来:

参考:

https://blog.csdn.net/qq_33713328/article/details/88748694

https://blog.csdn.net/u011242657/article/details/79027910

https://my.oschina.net/shyloveliyi/blog/790227

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)