IK分词器详解

IK分词器详解

·

什么是IK分词器

分词:即把一段中文或者别的划分成一个个的关键字,我们在搜索时会把自己的信息进行分词,会把数据库中或则索引库中的数据进行分词,然后进行一个匹配操作,默认的中文分词是将每个字看成一个词,比如“我爱王尧天”会被分为:“我”,“爱”,“王”,“尧”,“天”,这显然是不符合要求的,所以我们需要安装中文分词器ik来解决这个问题。

Ik提供了两个分词算法: ik_smart和ik_max_word,其中ik_smart为最少切分,ik_max_word为最细粒度划分!一会我们进行测试

安装

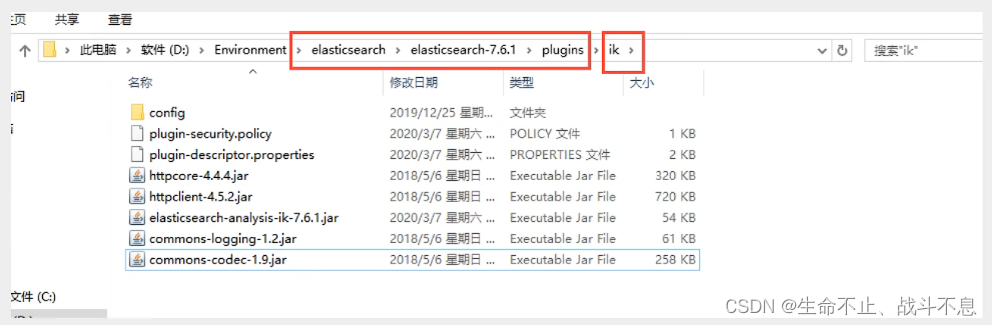

2、下载完毕之后,放入我们的elasticsearch插件中即可!

3、重启观察ES,可以看到ik分词器被加载了

4、elasticsearch-plugin 可以通过这个命令来查看加载进来的插件

5、使用kibana测试!

查看不同的分词效果

ik_smart为最少切分

ik_max_word为最细粒度划分!穷尽词库的可能 字典

我们输入 超级喜欢王尧天

发现问题:王尧天被拆开了

这种自己需要的词,需要自己加到我们分词器的字典中

ik分词器增加自己的配置!

重启ES 看细节

再次测试一下王尧天,看下效果

以后的话,我们需要自己配置 ,分词就在自己定义的dic文件中进行配置即可

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)