linux上传文件夹到hdfs,Linux上传本地文件到Hadoop的HDFS文件系统

记录如何将本地文件上传至HDFS中前提是已经启动了hadoop成功(nodedate都成功启动)①先切换到HDFS用户②创建一个input文件夹zhangsf@hadoop1:~$ hdfs dfs -mkdir /input查看创建的文件夹在 hadoop1:50070中查看(我自己的对应的是: http://192.168.5.130:50070) ③将本地文件上传到HDFS,前面为 服务器.

记录如何将本地文件上传至HDFS中

前提是已经启动了hadoop成功(nodedate都成功启动)

①先切换到HDFS用户

②创建一个input文件夹

zhangsf@hadoop1:~$ hdfs dfs -mkdir /input

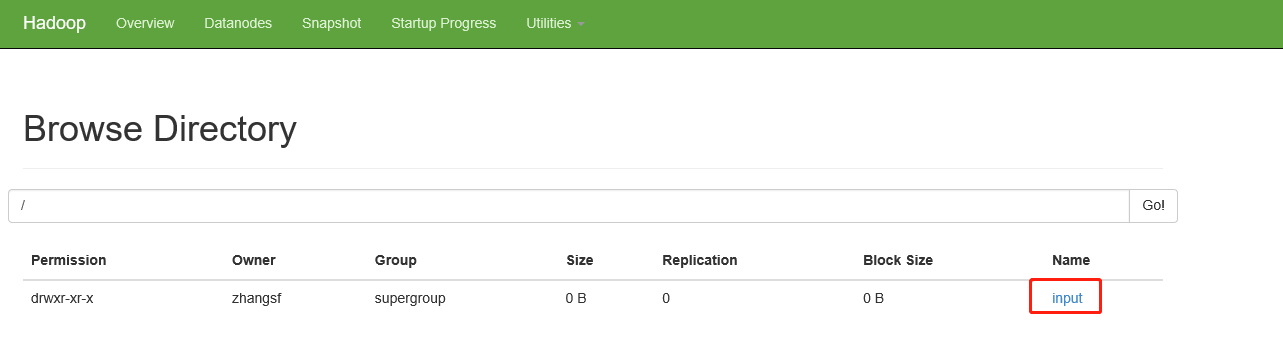

查看创建的文件夹在 hadoop1:50070中查看(我自己的对应的是: http://192.168.5.130:50070)

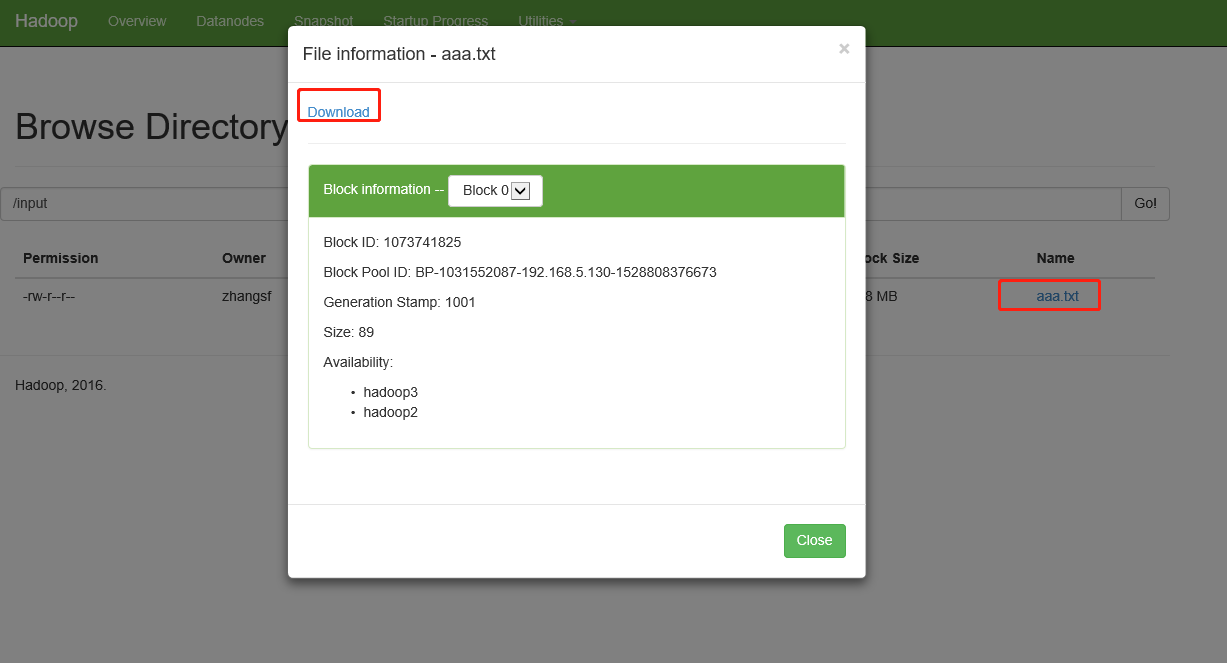

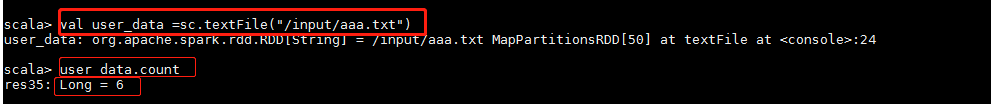

③将本地文件上传到HDFS,前面为 服务器中的文件路径,后面为HDFS中路径

zhangsf@hadoop1:~$ hdfs dfs -put /home/zhangsf/aaa.txt /input

zhangsf@hadoop1:~$ hdfs dfs -ls /input

Found 1 items

-rw-r--r-- 2 zhangsf supergroup 89 2018-06-12 06:03 /input/aaa.txt

其中 aaa.txt 是本地文件

zhangsf@hadoop1:~$ ls

aaa.txt data hadoop hadoop2 opt package

zhangsf@hadoop1:~$ pwd

/home/zhangsf

查看自己上传成功了,也可以进入hadoop1:7077的

Browse Directory中查看

查看

上传成功ok!

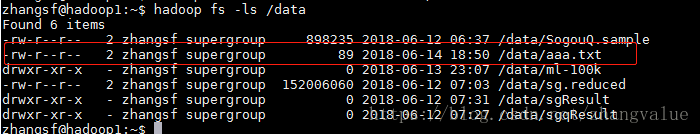

方法二: 使用moveFromLocal指令

zhangsf@hadoop1:~$ hadoop fs -moveFromLocal aaa.txt /data

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)