Nginx限流

文章目录1. 生活中限流对比2. nginx的限流2.1控制速率2.1.1 漏桶算法实现控制速率限流2.1.2 nginx的配置2.1.3 处理突发流量2.2 控制并发量(连接数)参考一般情况下,首页的并发量是比较大的,即使 有了多级缓存,当用户不停的刷新页面的时候,也是没有必要的,另外如果有恶意的请求 大量达到,也会对系统造成影响。而限流就是保护措施之一。1. 生活中限流对比水坝泄洪,通过闸口限

一般情况下,首页的并发量是比较大的,即使 有了多级缓存,当用户不停的刷新页面的时候,也是没有必要的,另外如果有恶意的请求 大量达到,也会对系统造成影响。

而限流就是保护措施之一。

1. 生活中限流对比

水坝泄洪,通过闸口限制洪水流量(控制流量速度)。

办理银行业务:所有人先领号,各窗口叫号处理。每个窗口处理速度根据客户具体业务而定,所有人排队等待叫号即可。若快下班时,告知客户明日再来(拒绝流量)

火车站排队买票安检,通过排队 的方式依次放入。(缓存带处理任务)

2. nginx的限流

nginx提供两种限流的方式:

一是控制速率

二是控制并发连接数

2.1控制速率

控制速率的方式之一就是采用漏桶算法。

2.1.1 漏桶算法实现控制速率限流

漏桶(Leaky Bucket)算法思路很简单,水(请求)先进入到漏桶里,漏桶以一定的速度出水(接口有响应速率),当水流入速度过大会直接溢出(访问频率超过接口响应速率),然后就拒绝请求,可以看出漏桶算法能强行限制数据的传输速率.示意图如下:

2.1.2 nginx的配置

特点:超过流量就立即被拒绝

配置示意图如下:

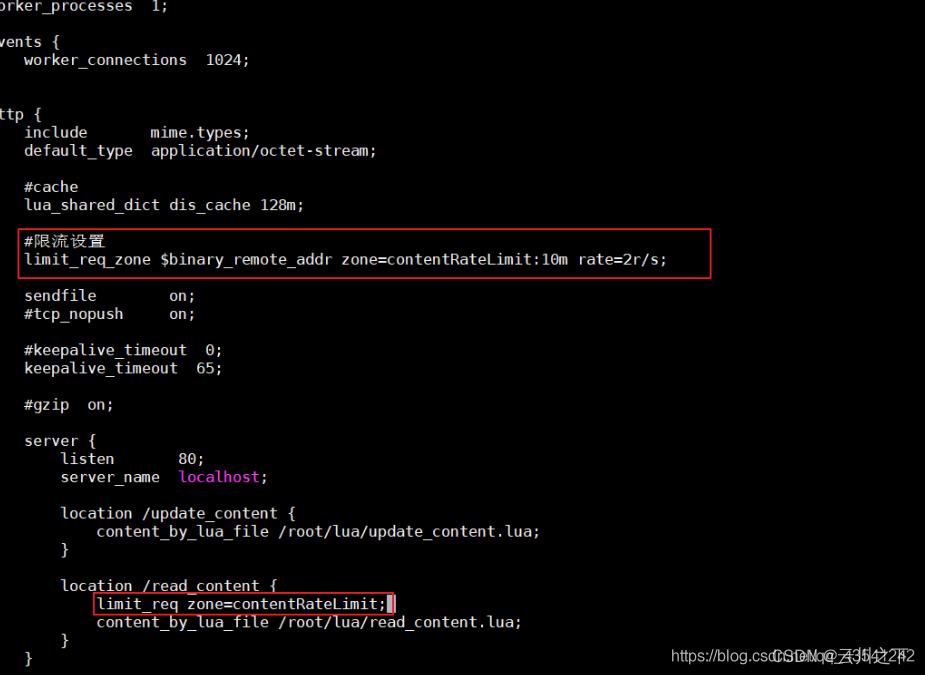

修改nginx.conf:

user root root;

worker_processes 1;

events {

worker_connections 1024;

}

http {

include mime.types;

default_type application/octet-stream;

#cache

lua_shared_dict dis_cache 128m;

#限流设置,这只是设置流量限制和共享内存区域的参数,但实际上并不限制请求速率。具体的限制需要定义具体的url

limit_req_zone $binary_remote_addr zone=contentRateLimit:10m rate=2r/s;

sendfile on;

#tcp_nopush on;

#keepalive_timeout 0;

keepalive_timeout 65;

#gzip on;

server {

listen 80;

server_name localhost;

location /update_content {

content_by_lua_file /root/lua/update_content.lua;

}

location /read_content {

#使用限流配置

limit_req zone=contentRateLimit;

content_by_lua_file /root/lua/read_content.lua;

}

}

}

配置说明:

-

binary_remote_addr是一种key,表示基于remote_addr(客户端IP) 来做限流,binary_ 的目的是压缩内存占用量。 -

zone:定义共享内存区来存储访问信息,

contentRateLimit:10m表示一个大小为10M,名字为contentRateLimit的内存区域(可以理解为限制规则的id)。1M能存储16000 IP地址的访问信息,10M可以存储16W IP地址访问信息。 rate 用于设置最大访问速率,rate=10r/s 表示每秒最多处理10个请求。Nginx 实际上以毫秒为粒度来跟踪请求信息,因此 10r/s 实际上是限制:每100毫秒处理一个请求。这意味着,自上一个请求处理完后,若后续100毫秒内又有请求到达,将拒绝处理该请求.我们这里设置成2 方便测试。limit_req_zone 限流设置,这只是定义了流量限制和共享内存区域的一个规则,但实际上并不限制请求速率。具体的限制需要定义具体的url,即在location /read_content 下引用该id

-

location /read_content 下引用限流规则

测试:

重新加载配置文件

cd /usr/local/openresty/nginx/sbin

./nginx -s reload

访问页面:http://XXXXXXX(你自己的请求路径!!!),连续刷新会直接报错(配置成功!)。

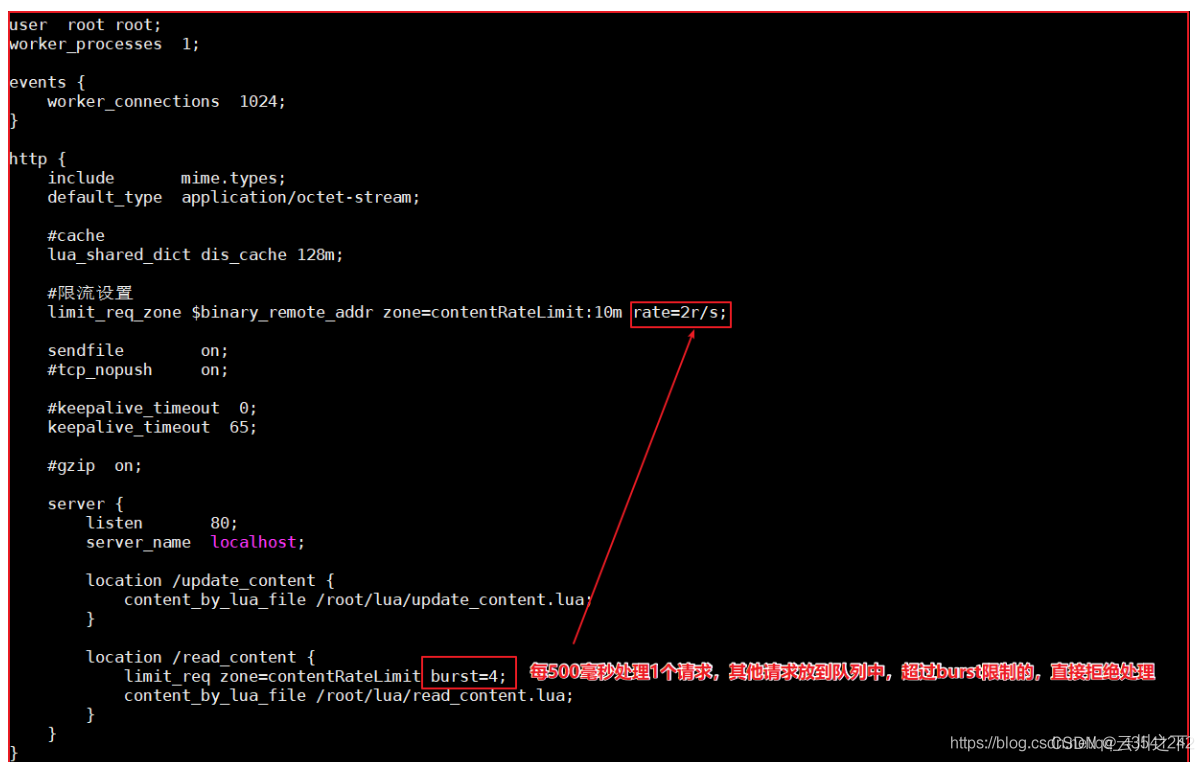

2.1.3 处理突发流量

特点:超过流量就不会立即被拒绝,允许加入一个队列,只有队列满了之后的请求才会被拒绝

上面例子限制 2r/s,如果有时正常流量突然增大,超出的请求将被拒绝,无法处理突发流量,可以结合 burst 参数使用来解决该问题。

例如,如下配置表示:

上图代码如下:

server {

listen 80;

server_name localhost;

location /update_content {

content_by_lua_file /root/lua/update_content.lua;

}

location /read_content {

limit_req zone=contentRateLimit burst=4;

content_by_lua_file /root/lua/read_content.lua;

}

}

burst 译为突发、爆发,表示在超过设定的处理速率后能额外处理的请求数,当 rate=10r/s 时,将1s拆成10份,即每100ms可处理1个请求。

此处,**burst=4 **,若同时有4个请求到达,Nginx 会处理第一个请求,剩余3个请求将放入队列,然后每隔500ms从队列中获取一个请求进行处理。若请求数大于4,将拒绝处理多余的请求,直接返回503.

不过,单独使用 burst 参数并不实用。假设 burst=50 ,rate依然为10r/s,排队中的50个请求虽然每100ms会处理一个,但第50个请求却需要等待 50 * 100ms即 5s,这么长的处理时间自然难以接受。因此单纯的增加burst的值(与rate相比的值),是没有意义的,这个值不会太大。

因此,burst 往往结合 nodelay 一起使用。

假设我们的流量是 2,1,4,0,2 模拟正常的请求,有个特点,存在峰值和谷值,代表每秒的请求数,这样当流控为2r/s,burst=4 nodelay时,在第3秒请求数为4时(峰值),仍然允许直接处理4个请求,但是后续的请求会被流程,保证总流量不超过2r/s,因此,当第四秒请求未0时,就起到了削峰填谷的作用。假设流量是2,1,4,4,4 ,峰值持续的时间比较长,那么从第二个峰值开始,就会被真的流控,被拒绝或进行排队,这样即使被处理,也会延迟稍高!

例如:如下配置:

server {

listen 80;

server_name localhost;

location /update_content {

content_by_lua_file /root/lua/update_content.lua;

}

location /read_content {

limit_req zone=contentRateLimit burst=4 nodelay;

content_by_lua_file /root/lua/read_content.lua;

}

}

如上表示:

平均每秒允许不超过2个请求,突发不超过4个请求,并且处理突发4个请求的时候,没有延迟,等到完成之后,按照正常的速率处理。

如上两种配置结合就达到了速率稳定,但突然流量也能正常处理的效果。完整配置代码如下:

user root root;

worker_processes 1;

events {

worker_connections 1024;

}

http {

include mime.types;

default_type application/octet-stream;

#cache

lua_shared_dict dis_cache 128m;

#限流设置

limit_req_zone $binary_remote_addr zone=contentRateLimit:10m rate=2r/s;

sendfile on;

#tcp_nopush on;

#keepalive_timeout 0;

keepalive_timeout 65;

#gzip on;

server {

listen 80;

server_name localhost;

location /update_content {

content_by_lua_file /root/lua/update_content.lua;

}

location /read_content {

limit_req zone=contentRateLimit burst=4 nodelay;

content_by_lua_file /root/lua/read_content.lua;

}

}

}

测试: 在1秒钟之内可以刷新4次,正常处理。 但是超过之后,连续刷新5次,抛出异常(配置成功!)。

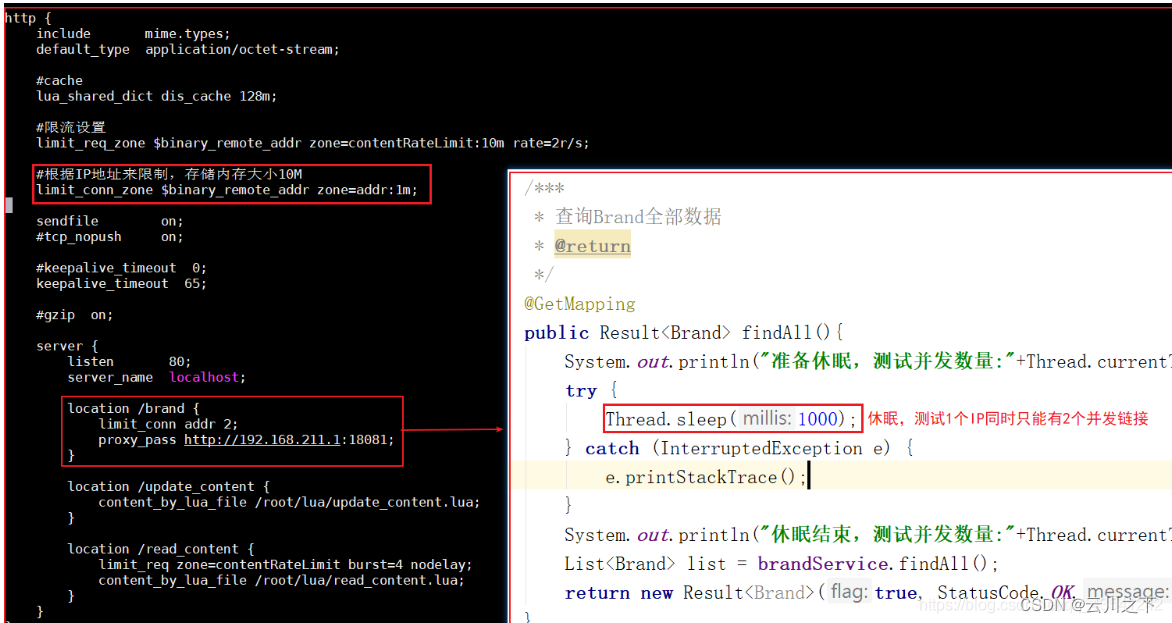

2.2 控制并发量(连接数)

ngx_http_limit_conn_module 提供了限制连接数的能力。主要是利用limit_conn_zone和limit_conn两个指令。

利用连接数限制 某一个用户的ip连接的数量来控制流量。

注意:并非所有连接都被计算在内 只有当服务器正在处理请求并且已经读取了整个请求头时,才会计算有效连接。此处忽略测试。

配置语法:

Syntax: limit_conn zone number;

Default: —;

Context: http, server, location;

(1)配置限制固定连接数

如下,配置如下:

上图配置如下:

http {

include mime.types;

default_type application/octet-stream;

#cache

lua_shared_dict dis_cache 128m;

#限流设置

limit_req_zone $binary_remote_addr zone=contentRateLimit:10m rate=2r/s;

#根据IP地址来限制,存储内存大小10M

limit_conn_zone $binary_remote_addr zone=addr:1m;

sendfile on;

#tcp_nopush on;

#keepalive_timeout 0;

keepalive_timeout 65;

#gzip on;

server {

listen 80;

server_name localhost;

#所有以brand开始的请求,访问本地changgou-service-goods微服务

location /brand {

limit_conn addr 2;

proxy_pass http://192.168.211.1:18081;

}

location /update_content {

content_by_lua_file /root/lua/update_content.lua;

}

location /read_content {

limit_req zone=contentRateLimit burst=4 nodelay;

content_by_lua_file /root/lua/read_content.lua;

}

}

}

表示:

limit_conn_zone $binary_remote_addr zone=addr:10m; 表示限制根据用户的IP地址来显示,设置存储地址为的内存大小10M

limit_conn addr 2; 表示 同一个地址只允许连接2次。

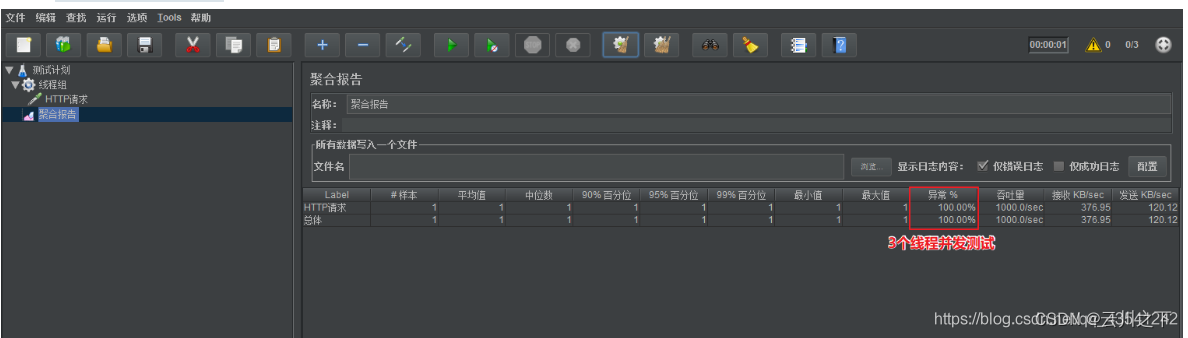

测试:

此时开3个线程,测试的时候会发生异常,开2个就不会有异常

(2)限制每个客户端IP与服务器的并发连接数,同时限制与服务器的连接总数。(了解)

如下配置:

limit_conn_zone $binary_remote_addr zone=perip:10m;

limit_conn_zone $server_name zone=perserver:10m;

server {

listen 80;

server_name localhost;

charset utf-8;

location / {

limit_conn perip 10;#单个客户端ip与服务器的连接数.

limit_conn perserver 100; #限制与服务器的总连接数

root html;

index index.html index.htm;

}

}

参考

更多推荐

已为社区贡献35条内容

已为社区贡献35条内容

所有评论(0)