5、Linux:如何将大文件切割成多份小文件

Linux 中如何将大文件切割成许多的小文件,且保持与大文件相同后缀

·

最近,在做数据文件的导入操作时,发现有些文本文件太大了,需要将这样的大文件切分成多个小文件进行操作。那么,Linux 中如何将大文件切割成许多的小文件呢?在此记录一下。

Linux 提供了 split 命令可以轻松实现大文件的分割,其命令格式如下:

split [操作大文件的参数] [大文件] [输出文件的可选参数] [输出文件名]其中,操作大文件的参数,有多种切分模式:

- -<行数> 或 -l <行数> :按行数切割,比如 -100,表示每 100 行切分成一个小文件。

- -b <行数> 或 -C <行数> :按字节数切割,比如 50M,表示每 50M 切分成一个小文件。-b 与 -C 的区别是,-C 按字节切割的同时会尽量保证每行的完整性。

输出文件的可选参数,控制输出文件形式:

- -d:使用数字作为后缀;

- -a <n>:如果以数字作为后缀时,则指定n位数;

- 不加任何参数及输出文件名的话,则输出文件则默认用 xaa,xab,....,xaz 等作为输出文件名,x 是文件的前导名,aa...az 是文件的后导名。

举例说明:

1、每3万行切割成一个小文件

[xxxxxxxxxx@localhost ~]$ split -l 30000 big_temp.log

[xxxxxxxxxx@localhost ~]$ ls

big_temp.log xaa xab xac xad xae xaf xag xah2、按3万切割,输出文件的导名加上3位数字

[xxxxxxxxxx@localhost ~]$ split -l 30000 big_temp.log -d -a 3 big_temp

[xxxxxxxxxx@localhost ~]$ ls

big_temp.log big_temp000 big_temp001 big_temp002 big_temp003

big_temp004 big_temp005 big_temp006 big_temp0073、每 50M 切割成一个小文件

[xxxxxxxxxx@localhost ~]$ split -b 50m big_temp.log

[xxxxxxxxxx@localhost ~]$ ls

big_temp.log xaa xab xac xad4、按 50M 切割,输出文件的后导名为系统默认

[xxxxxxxxxx@localhost ~]$ split -b 50m big_temp.log big_temp

[xxxxxxxxxx@localhost ~]$ ls

big_temp.log big_tempaa big_tempab big_tempac big_tempad实操如下:

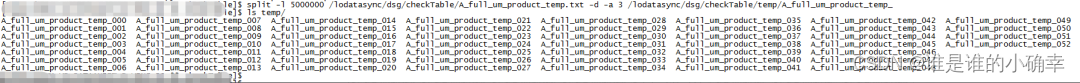

有一个数据量约 72G 的文本文件,现在按照 500w 行切割成小文件,效果如下:

最后

不知道有没有注意到,大文件分割成许多的小文件之后,小文件是没有后缀的,也就是小文件没有文件类型,这显然是需要加后缀的。那么,该如何批量对这些文件进行添加后缀名呢?

Linux 中的 mv 命令可以实现对单个文件加后缀名,然后结合 for 循环则可以轻易实现批量操作了,如下:

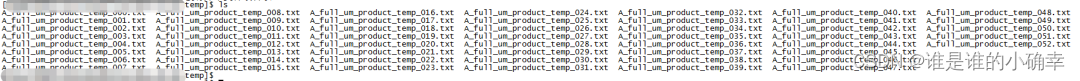

for i in `ll *_temp*`; do mv -f $i $i.txt;done加上 txt 后缀,效果如下:

至此,就实现了将大文件切割成多份小文件,且保持与大文件相同后缀的目标了。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)